在人工智能领域,随着深度学习模型的逐步发展,如何在保持模型性能的同时,降低计算复杂度和资源消耗,成为了一个至关重要的问题。模型蒸馏(Knowledge Distillation)作为一种有效的技术,帮助将复杂且庞大的教师模型的知识迁移到小型且高效的学生模型中,为高效计算提供了解决方案。本文将深入探讨蒸馏技术的定义、原理及其在DeepSeek中的创新实践。

1. 模型蒸馏技术概述

1.1 蒸馏技术的定义与原理

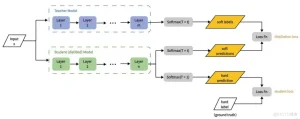

模型蒸馏(Knowledge Distillation)是一种将大型复杂模型(教师模型)的知识迁移到小型高效模型(学生模型)的技术。核心目标是:

- 在保持模型性能的同时,显著降低计算复杂度和存储需求,使得模型能够适应资源受限的环境。

蒸馏技术的原理:

- 教师模型训练:首先训练一个性能强大的教师模型,通常具有大量的参数和复杂的结构。

- 数据准备:提取教师模型的推理数据样本,用于训练学生模型。

- 学生模型训练:利用教师模型的输出作为监督信号,训练较小的学生模型。

- 优化与调整:调整学生模型的结构和参数,以确保其在保持高效的同时,尽可能接近教师模型的性能。

2. DeepSeek蒸馏技术的关键创新

2.1 数据蒸馏与模型蒸馏的结合

DeepSeek的蒸馏技术突破了传统蒸馏方法,将数据蒸馏与模型蒸馏相结合,从而进一步提升了蒸馏效率和性能。

数据蒸馏:

- 通过优化训练数据,帮助小模型更高效地学习。DeepSeek利用教师模型生成或优化数据,包括数据增强、伪标签生成等,确保训练数据的多样性和代表性。

模型蒸馏:

- 使用监督微调(SFT),DeepSeek将教师模型的知识迁移到学生模型中。通过生成800,000个推理数据样本,DeepSeek优化了学生模型的训练过程,无需额外的强化学习阶段,提升了蒸馏过程的效率。

结合的优势:

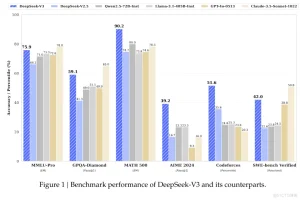

- 这种数据与模型蒸馏的结合使得DeepSeek的蒸馏模型在多个基准测试中取得了显著的性能提升,且计算资源需求大幅降低,使得模型更加适合在资源受限的环境中部署。

2.2 高效的知识迁移策略

DeepSeek在知识迁移策略上进行了多项创新,使得蒸馏过程更为高效,模型性能得到了显著提升。

知识迁移策略:

- 基于特征的蒸馏:通过将教师模型中间层的特征信息传递给学生模型,帮助学生模型更好地捕捉数据的本质特征。

- 特定任务蒸馏:针对不同的任务(如文本生成、机器翻译),DeepSeek对蒸馏过程进行了专门的优化,确保模型在特定任务上取得优异成绩。

性能提升:

- 这些策略使得DeepSeek的蒸馏模型在多个基准测试中表现优异。例如,在AIME 2024的测试中,DeepSeek-R1-Distill-Qwen-32B取得了72.6%的Pass@1,超越了许多领先的开源模型。

3. DeepSeek蒸馏模型的架构与训练

3.1 蒸馏模型架构设计

DeepSeek的蒸馏模型架构设计着重于性能与效率的平衡,通过优化的结构实现从大型复杂模型到小型高效模型的顺利迁移。

教师模型与学生模型选择:

- 教师模型:DeepSeek选择了具有671B参数的DeepSeek-R1作为教师模型,具备强大的推理能力和广泛的知识覆盖。

- 学生模型:基于Qwen和Llama系列架构,这些模型在计算效率和内存占用方面表现出色。

架构设计的关键点:

- 层次化特征提取:教师模型通过生成多层特征表示,学生模型通过学习这些表示,从而更好地理解数据结构和模式。

- 多任务适应性:学生模型不仅学习教师模型的输出,还根据具体任务(如文本分类、翻译)调整结构和参数。

3.2 训练过程与优化方法

DeepSeek的蒸馏训练过程包括以下关键步骤:

数据准备:

- 数据来源:通过教师模型生成推理数据样本,增强数据多样性,从而提高学生模型的学习效率。

训练策略:

- 监督微调(SFT):将教师模型的输出作为监督信号,学生模型通过学习这些输出进行优化。

- 混合损失函数:结合软标签损失和硬标签损失,鼓励学生模型模仿教师模型的输出,同时保证准确性。

优化方法:

- 温度参数调整:通过调整温度参数,使得软标签分布更加平滑,帮助学生模型更好地学习教师模型的输出。

- 动态学习率调整:根据训练进度动态调整学习率,确保模型训练的稳定性和收敛速度。

4. 蒸馏模型的性能表现

4.1 推理效率提升

DeepSeek的蒸馏模型在推理效率方面实现了显著提升,尤其在计算资源、内存使用和推理速度上。

性能提升:

- 计算资源优化:DeepSeek-R1-Distill-Qwen-7B仅有7B参数,相比原始模型的671B参数,计算复杂度大幅降低。

- 内存占用减少:以DeepSeek-R1-Distill-Llama-8B为例,内存占用减少至原模型的1/80。

- 推理速度提升:DeepSeek-R1-Distill-Qwen-32B在推理速度上比原始模型提高了约50倍,显著加快了响应速度。

4.2 性能与原始模型对比

尽管学生模型的参数量减少,但通过创新的知识迁移策略,DeepSeek的蒸馏模型依然能够保持或超越原始大型模型的性能。

性能对比:

- DeepSeek-R1-Distill-Qwen-7B在AIME 2024上达到了55.5%的Pass@1,超越了QwQ-32B-Preview(先进开源模型)。

- DeepSeek-R1-Distill-Qwen-32B在多个任务中取得了优异成绩,证明了蒸馏技术在保证性能的同时降低了计算成本。

5. 蒸馏技术的挑战与展望

5.1 突破“隐性天花板”

尽管DeepSeek的蒸馏技术已取得显著成果,但仍然面临学生模型性能的瓶颈,即学生模型无法超越教师模型的能力限制,尤其在新领域或复杂任务中。

5.2 多模态数据的蒸馏挑战

处理多模态数据(如图像、文本、语音)是蒸馏技术面临的另一大挑战。多模态数据的复杂性和计算需求,使得蒸馏过程更加困难。

挑战:

- 数据融合与语义对齐:不同模态数据的融合及其语义对齐是蒸馏过程中亟需解决的难题。

- 计算资源需求高:多模态数据处理需要更高的计算资源,增加了蒸馏过程的复杂性。

总结

DeepSeek的蒸馏技术通过数据与模型蒸馏的结合,以及创新的知识迁移策略,成功在性能和计算效率之间取得平衡。尽管技术面临一些挑战,但其在多个基准测试中的优异表现,表明蒸馏技术在资源受限环境中的广泛应用前景。